Colmap命令行稀疏重建与位姿导出

Colmap概述

Colmap是一个开源的基于图像的稀疏重建工具,目前的sfm的标杆工具箱。不过虽然Colmap是基于C++写的,但是主要使用方式还是通过命令行来使用,C++没有API文档,对应的pycolmap也没有详细文档。

因为一般Colmap是在服务器上运行的,要先按照文档装好CUDA环境,然后需要在对应的CmakeLists.txt中关闭GUI选项,然后编译安装即可。

最好启用GPU,因为在特征提取时用的GPU-SIFT可以显著加速特征提取。

Colmap命令行方式来进行稀疏重建

Colmap稀疏重建分为下面几个步骤:

- 准备需要重建的图像和相机参数

- 特征提取:使用SIFT提取特征,可以配置相机参数

- 特征匹配:可以配置多种匹配方式

- 建图:可以配置直接稀疏建图或分段稀疏建图

- 特征点三角化(可选):如果是分段重建那么往往在建图后三角化

- 全局BA(可选):如果是分段重建那么往往在三角化后进行全局BA

特征提取

特征提取非常简单:

1 | colmap feature_extractor \ |

因为一般相机都是通过OPENCV标定的,所以直接在Colmap里设置成OPENCV即可;然后需要设置相机参数,这个参数是相机内参,分别是fx,fy,cx,cy,k1,k2,p1,p2,这些内参直接用字符串的方式传进去即可。也就是设置--ImageReader.camera_params "fx,fy,cx,cy,k1,k2,p1,p2"和--ImageReader.camera_model OPENCV。

而因为是一个相机录制一段视频,所以设置--ImageReader.single_camera 1即可。

特征匹配

特征匹配有多种算法,这里列出几个常用的,分别是exhaustive_matcher、sequential_matcher和vocab_tree_matcher。

实际测试下来2000张左右的图像,直接用exhaustive_matcher就行,大概10分钟就能完成匹配。

exhaustive_matcher

暴力匹配,也就是把每个图像与其他图像进行匹配,速度比较慢,但是对于几百张图片效果很好。

1 | colmap exhaustive_matcher \ |

sequential_matcher

序列匹配,针对顺序采集的视频图像,由于相邻帧存在视觉上的重叠且没有必要进行完全匹配,它只匹配视频流中的相邻帧。同时,这种匹配方式能够基于vocabulary tree进行回环检测。

1 | colmap sequential_matcher \ |

vocab_tree_matcher

针对大量图像(几千帧量级),可以通过提供vocabulary tree从而快速检索视觉上最相近的图像进行匹配。

1 | colmap vocab_tree_matcher \ |

建图

建图有两种方式,一种是直接建图,一种是分段建图。

分段建图是有一个bug的,如果你的帧太少,colmap总共只分了一个段出来,那么在merge的时候会报错,这时候需要修改对应的colmap的源码来解决。

所以少量图像直接建图即可。

通常都是使用直接建图,除非你的图像特别多才会使用分段建图。这里给出几个参考(可能由于配置不同而存在差异):

- 300张图像左右,直接建图大概耗时10分钟

- 600张图像左右,直接建图大概耗时30分钟

- 1400张图像左右,直接建图大概耗时540分钟

直接建图

1 | colmap mapper \ |

最后这个--Mapper.ba_refine_principal_point是用来优化主点的,可以按需添加。

分段建图

实际测试下来,用sequential_matcher和hierarchical_mapper来对视频进行重建效果不咋地,可能是拍摄的时候运动模糊太大了导致的。

并且官方文档上推荐在执行完分段建图后最好还额外执行几轮三角化和全局BA。

1 | colmap hierarchical_mapper \ |

特征点三角化

1 | colmap point_triangulator \ |

全局BA

1 | colmap bundle_adjuster \ |

稀疏重建后位姿导出与使用

上面已经完成了稀疏重建,可以在sparse/x找到对应的bin文件,这个x是一个数字,代表的是重建的序号,一般是0,但是如果一次重建效果很差,colmap会自动重试最多三次。

这个bin文件是一个二进制文件,里面存储了重建的信息,可以通过下面的命令来导出:

1 | colmap model_converter 、 |

这样就能得到三个txt文件,其中保存相机位姿和点云的文件为images.txt。这个文件从第五行开始,奇数行代表对应的帧和位姿,偶数行表示上一个奇数行的帧观测到的点云。

不过注意,这里的位姿并不能直接是相机位姿,而是世界坐标系到相机的位姿,所以需要进行变换才能使用。

也就是

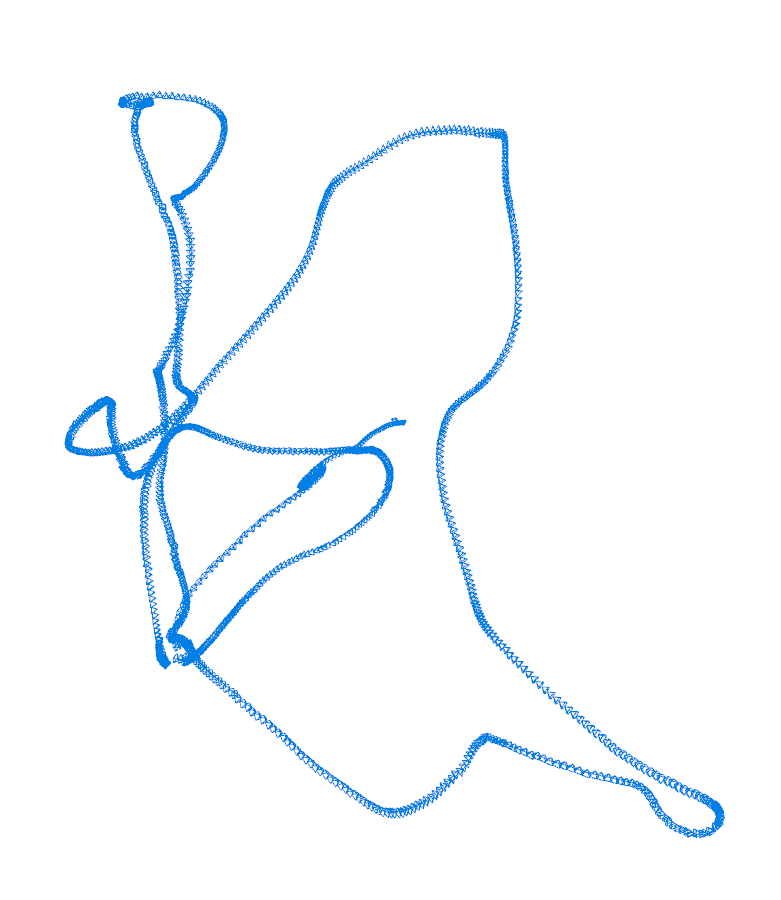

下面给出一个简单的python代码来读取这个文件并使用open3d来绘制相机轨迹图

1 | import time |

注意,Colmap生成的IMAGE_ID不一定是真实的顺序,所以如果是视频的话最好按照拆帧时的序号来对位姿进行排序。

比如,一个视频拆分成形如frame_052.jpg的格式,就如上述代码中的

1 | frame, pose = line.strip("\n").split(" ", 1) |

来对所有位姿进行重排

这样就能得到colmap重建后的相机轨迹图了。